Evolución de la conectividad dentro del centro de datos: cómo satisfacer las demandas de las cargas de trabajo de próxima generación

La conectividad entre centros de datos (que conecta servidores, conmutadores y almacenamiento en una sola instalación) ha experimentado cambios importantes en la última década. Si bien Spine-Leaf sigue siendo la arquitectura líder por su escalabilidad y rendimiento predecible, están surgiendo nuevas topologías para satisfacer las necesidades. crecientes demandas de Inteligencia Artificial (IA), aprendizaje automático y otras cargas de trabajo de alto rendimiento.

Al mismo tiempo, los avances en la tecnología de transceptores desempeñan un papel fundamental en la habilitación de estos nuevos diseños de red. A medida que evolucionan las cargas de trabajo de los centros de datos, especialmente con la IA, el almacenamiento desagregado y el análisis en tiempo real, los transceptores deben ofrecer velocidades más rápidas, mayor alcance y mayor eficiencia energética. Estas mejoras influyen directamente en qué topologías son viables y rentables.

Vamos a explorar Hacia dónde se dirige la tecnología del transceptor, cómo soporta topologías en evolución y qué es lo próximo para las redes que impulsan las cargas de trabajo modernas.

¿Cómo está evolucionando la arquitectura intra-centro de datos para la IA?

La red de centros de datos actual se divide en dos dominios fundamentales:

-

- Red front-endEsta es la estructura de red convencional que conecta servidores y almacenamiento con usuarios y aplicaciones. Se trata principalmente de tráfico este-oeste (servidor a servidor) con un salto final norte-sur hacia el exterior mediante enrutadores de borde o nodos de interconexión de centros de datos (DCI).

-

- Red de back-end:Diseñada específicamente para la infraestructura de IA/ML, la red de back-end forma la columna vertebral de Topologías de clústeres de IA—estructuras de cómputo dedicadas y de alto rendimiento que interconectan GPU y aceleradores. Este entorno es privado, sensible a la latencia y está aislado de la red pública de internet, optimizado para comunicaciones de alto ancho de banda y estrechamente acopladas.

El auge de las redes back-end marca un cambio, no solo en la arquitectura, sino también en los requisitos de interconexión. Y es ahí donde los transceptores enchufables están experimentando su mayor transformación hasta la fecha.

¿Cuál es la diferencia entre redes de escalamiento vertical y horizontal?

1. Red de ampliación

El escalamiento vertical se refiere a la adición de más recursos, como unidades de procesamiento gráfico (GPU) o memoria, dentro de un solo nodo o sistema estrechamente conectado. En clústeres de IA, permite una comunicación de baja latencia y alto ancho de banda entre GPU para que actúen como un recurso computacional unificado, como una única "superGPU", a menudo dentro del mismo rack o chasis.

Históricamente, la red de ampliación dependía únicamente de transceptores basados en cobre, tanto en Cables de cobre de conexión directa (DAC) pasivos o con la adición de componentes activos (AEC/ADAC). Con velocidades de datos más altas de 800G o 1,6T, los transceptores basados en cobre podrían no alcanzar la distancia suficiente o las capacidades adecuadas de administración de cables, por lo que los transceptores basados en tecnología óptica (enchufables, LPO, LRO, etc.) también están comenzando a abrirse camino en esta sección.

2. Red escalable

El escalamiento horizontal implica conectar múltiples nodos de cómputo o clústeres de GPU entre racks o salas de datos para ampliar la capacidad. Admite cargas de trabajo distribuidas y requiere interconexiones ópticas de alta velocidad para mantener el rendimiento a largas distancias. En este caso, el escalamiento horizontal requiere transceptores ópticos de mayor alcance, por lo que los transceptores de solo cobre no son una opción viable.

los Consorcio Ultra Ethernet Trabaja activamente para adaptar los estándares Ethernet a estas cargas de trabajo de IA, especialmente en cuanto a baja latencia y cero pérdida de paquetes, lo que impulsa aún más la innovación en el diseño de transceptores y sistemas. Entre marzo y abril de 2025, Heavy Reading (ahora parte de Omdia) encuestó a 103 profesionales de proveedores de servicios de todo el mundo, obteniendo información clave sobre el crecimiento de los centros de datos de IA, la evolución de la red y la optimización. Al preguntar a los encuestados qué velocidades de red implementan en la infraestructura de su centro de datos de IA/ML, la mayoría (55%) afirmó utilizar 400G, mientras que 34% afirmaron utilizar 800G. Un pequeño número (22%) ya utiliza 1,6T o más, lo que demuestra que las implementaciones de IA en centros de datos están impulsando la velocidad de las redes más que cualquier otra aplicación.

¿Cómo han allanado el camino los transceptores 400G para las implementaciones de próxima generación?

400G, disponible en dos formatos clave: QSFP-DD y OSFP, ha sido una tecnología clave para el desarrollo de implementaciones dentro de centros de datos durante los últimos cinco años. Estos dos formatos utilizan 400G comúnmente en esta configuración: 8 líneas eléctricas PAM4 de 56G con diferentes combinaciones de opciones de medios, por ejemplo, cobre (DAC pasivos y activos) y ópticos (8x50G, 4x100G, 1x400G, etc.). A 400G, el QSFP-DD Ha ganado la mayor tracción/volumen al ofrecer menor consumo de energía, alta densidad y compatibilidad con versiones anteriores de los transceptores QSFP/QSFP28.

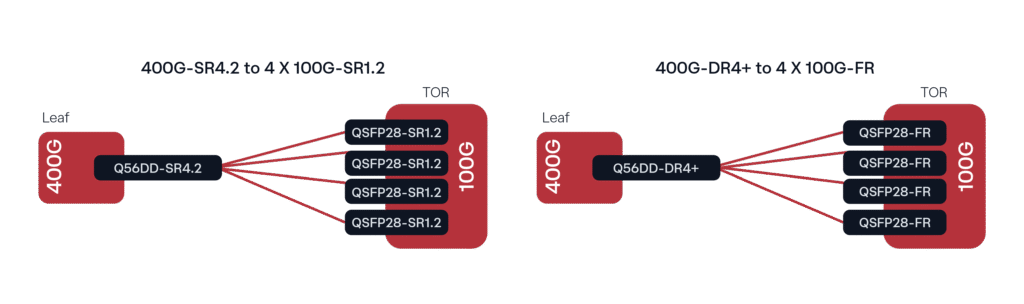

Una implementación común, especialmente con Leaf y TOR (top of rack), consiste en conectar transceptores DR4/DR4+ de 400G a ópticas Lambda individuales de 100G (DR o FR de 100G, según la distancia) mediante fibra monomodo (SMF). Una implementación similar con fibra multimodo (MMF) sería la conexión de 400G SR4.2 a 4 x 100G SR1.2.

Figura 1. Configuraciones comunes de implementación de 400G

¿Por qué 112G PAM4 es un facilitador clave para las soluciones conectables emergentes?

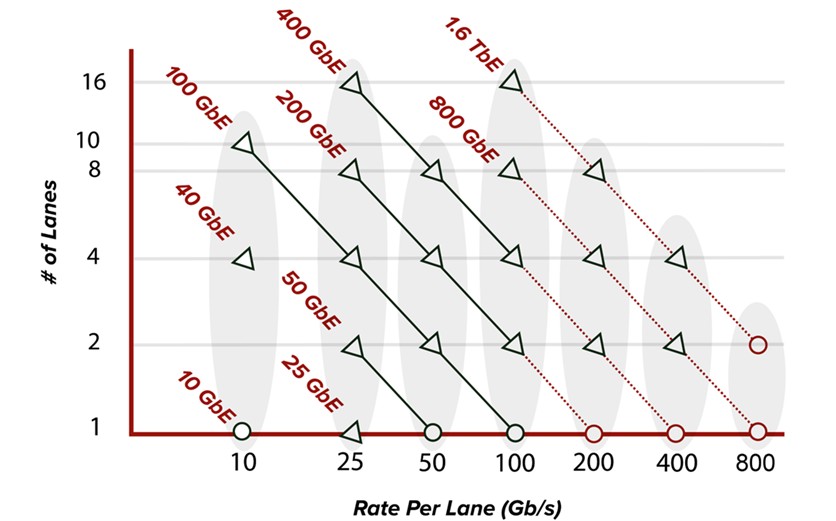

A medida que aumentan las velocidades de datos de las líneas eléctricas, los nuevos factores de forma, como QSFP112, QSFP-DD800 y OSFP800 (todos con capacidades de línea eléctrica de 112 G), se están integrando en el ecosistema de los centros de datos. La demanda de ancho de banda sigue en aumento, impulsada principalmente por los hiperescaladores y el desarrollo de GPU para IA, lo que hace que la óptica de 800 G sea muy común en la estructura de red. Como se muestra en la Figura 2, el aumento de la velocidad por línea permite un mayor ancho de banda. Los transceptores de 400 G, por ejemplo, solían tener ocho líneas de hasta 56 G PAM4 para alcanzar 400 GbE. Ahora, los dispositivos conectables de 400 G utilizan cuatro líneas eléctricas PAM4 de 112 G (QSFP112/OSFP) y, de forma similar, los dispositivos conectables de 800 G utilizan ocho líneas eléctricas PAM4 de 112 G (QSFP-DD800/OSFP800).

Figura 2. Evolución de la velocidad de la vía estándar de Ethernet

En cuanto a los medios, las opciones de conexión se han ampliado para incluir conectores MPO-16 con capacidad de 8 x 100 G, así como conectores MPO duales o LC/CS dúplex duales que permiten conexiones ópticas de 2 x 400 G. Con el aumento de las velocidades de datos, se han introducido numerosos tipos de conectores nuevos para adaptarse al aumento de aplicaciones, incluyendo algunos nuevos tipos de factor de forma muy pequeño (VSFF), como CS, SN, MDC, etc. Si bien los conectores VSFF llevan tiempo disponibles y se utilizan ocasionalmente para 400 G, recientemente se han adoptado ampliamente para la conectividad de 800 G, ya que permiten una densidad mucho mayor por unidad de rack en las necesidades de gestión de cableado de los centros de datos.

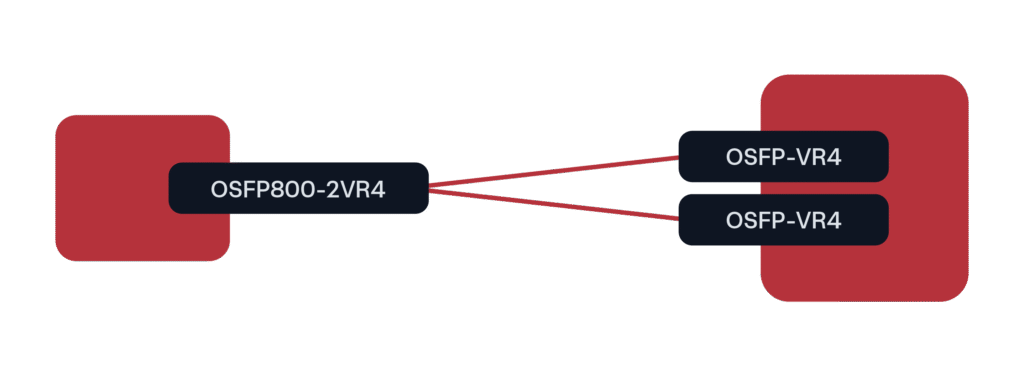

Para las implementaciones de GPU a 800G, el factor de forma líder hasta el momento ha sido OSFP800 en una configuración de conexión 2x400G a QSFP112 u OSFP (a velocidades de 400G).

Figura 3. Escenario de implementación predominante de 800G para clústeres de GPU/IA

QSFP-DD también está disponible para esta configuración de expansión, pero no ha tenido tanta aceptación en implementaciones de hiperescaladores/IA. Esperamos que el formato QSFP-DD siga teniendo cabida en el sector de las telecomunicaciones/MSO una vez que comiencen a implementar 800G.

¿Qué sigue para la conectividad dentro del centro de datos?

La próxima generación de transceptores ópticos para aplicaciones intracentros de datos está impulsada por la demanda de mayor ancho de banda y escalabilidad, especialmente en entornos con alta demanda de IA y GPU. Están surgiendo nuevos formatos, como OSFP-XD y QSFP-DD1600, compatibles con conectores de 1,6 Tbps, donde OSFP-XD lidera en rendimiento y escalabilidad futura. Diseñado con 16 líneas eléctricas PAM4 de 112 Gbps y compatible con 8 líneas de 224 Gbps, OSFP-XD no solo permite la óptica actual de 1,6 Tbps, sino también una ruta despejada hacia los 3,2 Tbps. Sus capacidades de gestión térmica más flexibles y su mayor capacidad de potencia lo hacen ideal para aplicaciones de alto rendimiento y velocidades de datos de última generación.

Además de los nuevos formatos genéricos conectables para transceptores, tecnologías como la Óptica Conectable Lineal (LPO) y la Óptica de Recepción Lineal (LRO) están ganando terreno para reducir el consumo energético sin comprometer el rendimiento. Si bien la Óptica Co-Empaquetada (CPO) promete una integración aún mayor, aún enfrenta desafíos significativos en términos de facilidad de servicio, compatibilidad y madurez del ecosistema. A medida que evoluciona la conectividad entre centros de datos, puede confiar en Belden y su marca Precision OT para seguir ofreciendo nuestra amplia experiencia en ingeniería de sistemas e integración de redes y ayudarle a navegar la continua evolución de los centros de datos. Desde la validación y compatibilidad de transceptores hasta el diseño de estrategias de conexión personalizadas y la gestión de las restricciones energéticas y térmicas, nuestro equipo trabaja como una extensión del suyo, garantizando que cada implementación esté optimizada para el rendimiento, la eficiencia y el crecimiento.

Usted también puede estar interesado en:

La guía definitiva para Wi-Fi administrado: confiabilidad, cobertura y rendimiento